หากคุณกำลังพัฒนาเว็บไซต์และต้องการปรับปรุงประสิทธิภาพด้าน SEO หนึ่งในองค์ประกอบที่ไม่ควรมองข้ามคือไฟล์ Robots.txt ไฟล์เล็ก ๆ ที่มีบทบาทสำคัญในการกำหนดว่าบอทของเสิร์ชเอนจินจะเข้าถึงส่วนใดของเว็บไซต์ได้บ้าง CIPHER จะพาไปทำความเข้าใจและตั้งค่าไฟล์นี้อย่างถูกต้อง ของ Robots.txt ที่จะช่วยให้เว็บไซต์ของคุณถูกจัดทำดัชนีได้อย่างมีประสิทธิภาพมากขึ้น

Table of Contents

Robots.txt คืออะไร?

Robots.txt คือ ไฟล์ข้อความธรรมดาที่อยู่ในโฟลเดอร์หลักของเว็บไซต์ (root directory) ทำหน้าที่เสมือน “คู่มือแนะนำทาง” สำหรับเว็บคลอว์เลอร์ (Web Crawler) หรือบอทของเสิร์ชเอนจิน (Search Engine) เมื่อบอทมาเยี่ยมชมเว็บไซต์ของคุณ สิ่งแรกที่พวกมันจะทำ คือ มองหาไฟล์ Robots.txt เพื่อตรวจสอบว่ามีส่วนไหนของเว็บไซต์ที่คุณอนุญาตหรือไม่อนุญาตให้พวกมันเข้าถึง

ลองนึกภาพว่า Robots.txt เป็นเหมือนยามรักษาความปลอดภัยที่คอยบอกบอทว่า “เชิญเข้ามาดูส่วนนี้ได้” หรือ “ขออภัย ห้ามเข้าบริเวณนี้” ซึ่งการควบคุมนี้มีความสำคัญอย่างยิ่งต่อการทำ SEO เว็บไซต์ของคุณ

Robots.txt สำคัญอย่างไรต่อการทำ SEO เว็บไซต์?

หลายคนอาจสงสัยว่าไฟล์เล็ก ๆ แค่นี้จะส่งผลต่อ SEO ได้อย่างไร ความจริงแล้ว Robots.txt มีบทบาทสำคัญมาก ๆ ในการเพิ่มประสิทธิภาพการทำ SEO ดังนี้

- ช่วยให้ Google เข้าใจโครงสร้างเว็บไซต์ของคุณได้ดีขึ้น – เมื่อคุณแนะนำให้เว็บคลอว์เลอร์รู้ว่าควรดูส่วนไหนและควรข้ามส่วนไหน เสิร์ชเอนจินจะเข้าใจว่าเนื้อหาส่วนไหนที่คุณต้องการให้ผู้ใช้เห็น ซึ่งช่วยให้ Google จัดลำดับความสำคัญในการคลอว์ลและทำดัชนีเนื้อหาของคุณได้อย่างมีประสิทธิภาพมากขึ้น

- ประหยัดโควต้าการคลอว์ล – เสิร์ชเอนจินมีข้อจำกัดในการคลอว์ลเว็บไซต์แต่ละแห่ง การมี Robots.txt ที่กำหนดไว้อย่างถูกต้องจะช่วยให้โควต้านี้ถูกใช้กับหน้าที่สำคัญจริง ๆ ไม่ต้องเสียเวลาไปกับหน้าที่ไม่จำเป็นต้องปรากฏในผลการค้นหา

- ป้องกันเนื้อหาที่ซ้ำซ้อน – คุณสามารถใช้ Robots.txt เพื่อบอกให้บอทไม่ต้องคลอว์ลหน้าที่มีเนื้อหาซ้ำกัน ซึ่งช่วยป้องกันปัญหา Duplicate Content ที่ส่งผลเสียต่อ SEO และอาจทำให้อันดับเว็บไซต์ของคุณลดลงได้

- ช่วยจัดการทรัพยากรเซิร์ฟเวอร์ – การจำกัดการเข้าถึงของบอทสามารถช่วยลดภาระของเซิร์ฟเวอร์ โดยเฉพาะสำหรับเว็บไซต์ขนาดใหญ่ ทำให้เว็บไซต์ของคุณโหลดเร็วขึ้นและมีประสบการณ์ผู้ใช้ที่ดีขึ้น ซึ่งเป็นปัจจัยสำคัญในการจัดอันดับของ Google

ข้อดีของการมีไฟล์ Robots.txt

การมีไฟล์ Robots.txt ที่ตั้งค่าอย่างเหมาะสมมอบประโยชน์มากมายให้กับเว็บไซต์ของคุณ โดยมีประโยชน์ดังนี้

- เพิ่มประสิทธิภาพในการทำงานของเว็บคลอว์เลอร์ – บอทจะใช้เวลาและทรัพยากรไปกับการคลอว์ลหน้าที่สำคัญเท่านั้น ทำให้หน้าสำคัญของคุณถูกพบและทำดัชนีได้เร็วขึ้น หน้าใหม่ของคุณจะปรากฏในผลการค้นหาได้เร็วกว่าเดิม

- ช่วยปกป้องข้อมูลส่วนตัว – คุณสามารถสั่งให้บอทไม่เข้าถึงหน้าที่มีข้อมูลละเอียดอ่อนได้ เช่น หน้าสมัครสมาชิก หน้าชำระเงิน หรือหน้าที่มีข้อมูลส่วนตัวของผู้ใช้ ทำให้ข้อมูลสำคัญไม่ปรากฏในผลการค้นหาของ Google

- ช่วยป้องกันปัญหาในการทำ SEO – เช่น การป้องกันไม่ให้เสิร์ชเอนจินนำหน้าทดสอบหรือหน้าร่างไปแสดงในผลการค้นหา ซึ่งอาจทำให้ผู้ใช้สับสนหรือได้รับประสบการณ์ที่ไม่ดีจากเว็บไซต์ของคุณ

- ช่วยในการปรับปรุงเว็บไซต์ – คุณสามารถป้องกันไม่ให้บอทเข้าถึงหน้าที่กำลังปรับปรุงได้ ทำให้สามารถพัฒนาเว็บไซต์ได้โดยไม่กระทบกับหน้าที่มีอยู่แล้วในผลการค้นหา ผู้ใช้จะไม่เจอหน้าที่ยังไม่เสร็จสมบูรณ์

ในเว็บไซต์ WordPress การสร้างและปรับแต่ง Robots.txt WordPress อย่างถูกต้องยิ่งมีความสำคัญเพราะแพลตฟอร์มนี้มักมีหน้าและโฟลเดอร์จำนวนมากที่คุณอาจไม่ต้องการให้ปรากฏในผลการค้นหา

ข้อควรระวังในการทำ Robots.txt

แม้ว่า Robots.txt จะมีประโยชน์มาก แต่การใช้งานอย่างไม่ถูกต้องอาจก่อให้เกิดปัญหาร้ายแรงกับ SEO ของคุณได้ ต่อไปนี้คือสิ่งที่คุณควรระวัง

- อย่าบล็อกเว็บคลอว์เลอร์ทั้งหมด – การใช้คำสั่ง User-agent: * Disallow: / จะห้ามไม่ให้บอททั้งหมดเข้าถึงเว็บไซต์ของคุณ ซึ่งหมายความว่าเว็บไซต์ของคุณจะไม่ปรากฏในผลการค้นหาเลย! หลายคนทำผิดพลาดนี้โดยไม่รู้ตัวและสงสัยว่าทำไมเว็บไซต์หายไปจาก Google

- ไม่ได้เป็นมาตรการรักษาความปลอดภัยที่สมบูรณ์ – Robots.txt เป็นเพียงคำแนะนำ ไม่ใช่การบังคับ บอทที่ไม่ดีสามารถละเลยคำสั่งเหล่านี้ได้ ดังนั้นอย่าใช้เพื่อซ่อนข้อมูลสำคัญที่ต้องรักษาความปลอดภัย เพราะใครก็ตามสามารถเข้าดู Robots.txt ของคุณได้

- ไม่ควรใช้แทนการซ่อนเนื้อหา – หากต้องการปกป้องข้อมูลอย่างแท้จริง ควรใช้การยืนยันตัวตนหรือวิธีอื่น ๆ แทน เช่น การใช้ .htaccess หรือระบบรักษาความปลอดภัยอื่น ๆ ที่เหมาะสมกว่า

- ใน WordPress การแก้ไข Robots.txt ผิดพลาดอาจส่งผลเสียหาย – ผู้ใช้ WordPress Robots.txt ควรเข้าใจผลกระทบของการแก้ไขก่อนทำการเปลี่ยนแปลง ควรทำการสำรองข้อมูลก่อนเสมอ และทดสอบว่าการเปลี่ยนแปลงไม่ส่งผลกระทบต่อการทำงานของเว็บไซต์

สคริปต์และคำสั่งในไฟล์ Robots.txt ที่ต้องรู้

User-agent

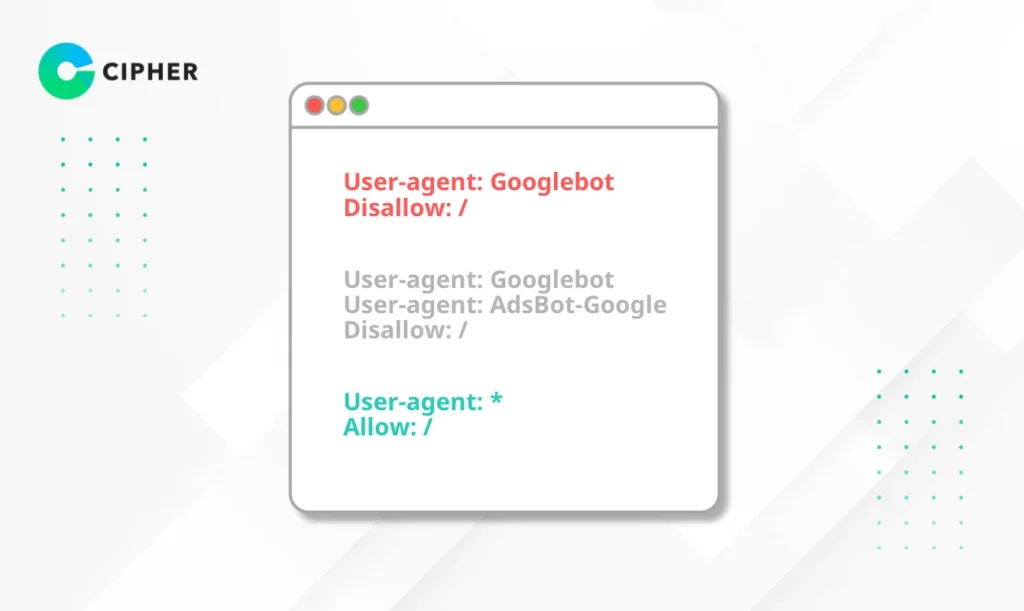

User-agent คือคำสั่งแรกที่ต้องระบุในไฟล์ robots.txt ซึ่งใช้กำหนดว่ากฎที่เราตั้งจะมีผลกับโปรแกรมค้นหา (Search Engine Bot) ตัวใด

- ถ้าต้องการให้กฎมีผลกับทุกโปรแกรมค้นหา ให้ใช้ *

- สามารถระบุโปรแกรมค้นหาเฉพาะได้ เช่น Googlebot, Bingbot หรือ Yahoobot

ตัวอย่าง

# ตัวอย่าง 1: ใช้กฎกับ Google เท่านั้น

User-agent: Googlebot

Disallow: /

# ตัวอย่าง 2: ใช้กฎกับหลายโปรแกรมค้นหา

User-agent: Googlebot

User-agent: AdsBot-Google

Disallow: /

# ตัวอย่าง 3: ใช้กฎกับทุกโปรแกรมค้นหา

User-agent: *

Allow: /

การกำหนด User-agent ที่แตกต่างกันช่วยให้คุณสามารถควบคุมการเข้าถึงของบอทแต่ละตัวแยกกันได้ เช่น อาจอนุญาตให้ Google เข้าถึงทุกส่วนแต่จำกัดการเข้าถึงของบอทอื่น ๆ

Disallow

คำสั่ง `Disallow` ใช้บอกว่าไม่อนุญาตให้เว็บคลอว์เลอร์เข้าถึงส่วนไหนของเว็บไซต์ คุณสามารถระบุเป็นโฟลเดอร์หรือไฟล์เฉพาะก็ได้ ยิ่งคุณกำหนดได้เฉพาะเจาะจง ยิ่งควบคุมได้ดี

ตัวอย่าง

Disallow: /admin/ # ห้ามเข้าถึงโฟลเดอร์ admin ทั้งหมด

Disallow: /wp-admin/ # สำหรับ WordPress ห้ามเข้าถึงหน้าแอดมิน

Disallow: /private-file.html # ห้ามเข้าถึงไฟล์เฉพาะ

คำสั่ง Disallow สำคัญมากในการปกป้องพื้นที่ที่ไม่ต้องการให้ปรากฏในผลการค้นหา เช่น หน้าแอดมิน ซึ่งมักมีข้อมูลสำคัญที่ไม่ควรเปิดเผย

Allow

คำสั่ง Allow คือคำสั่งที่อนุญาตให้โปรแกรมค้นหาเข้าถึงหน้าเว็บหรือโฟลเดอร์ที่ระบุ แม้ว่าจะมีคำสั่ง Disallow อยู่ก่อนแล้ว ใช้สร้างข้อยกเว้นสำหรับคำสั่ง Disallow รูปแบบการเขียนเหมือนกับ Disallow

ตัวอย่าง

# ตัวอย่าง: ห้ามเข้าถึงทั้งหมดแต่อนุญาตเฉพาะโฟลเดอร์ public

User-agent: *

Disallow: /

Allow: /public/

# ตัวอย่าง: อนุญาตทั้งเว็บไซต์

User-agent: *

Allow: /

ความเฉพาะเจาะจงนี้ช่วยให้คุณสามารถควบคุมการเข้าถึงได้อย่างละเอียด โดยที่ไม่ต้องเปิดหรือปิดทั้งหมด

Sitemap

คำสั่ง Sitemap ช่วยให้เว็บคลอว์เลอร์รู้ว่าแผนผังเว็บไซต์ของคุณอยู่ที่ไหน ซึ่งเป็นไฟล์ที่แสดงรายการหน้าทั้งหมดที่คุณต้องการให้ปรากฏในผลการค้นหา ช่วยให้เสิร์ชเอนจินพบและทำดัชนีหน้าเว็บของคุณได้ง่ายขึ้น

ตัวอย่าง

Sitemap: https://www.yourwebsite.com/sitemap.xml

การระบุ Sitemap ในไฟล์ Robots.txt จะช่วยให้เสิร์ชเอนจินค้นพบหน้าใหม่ของคุณได้เร็วขึ้น และเข้าใจโครงสร้างเว็บไซต์ได้ดีขึ้น ซึ่งส่งผลดีต่อการทำ SEO

วิธีการสร้างไฟล์ Robots.txt

1. วิธีสร้างไฟล์ Robots.txt ไปวางในเว็บไซต์ด้วยตัวเอง

เขียนไฟล์ Robots.txt ใน Notepad (Windows) หรือ TextEdit (Mac)

- เปิดโปรแกรม Text Editor เช่น Notepad, TextEdit หรือ VS Code

- เขียนคำสั่งที่ต้องการลงไป

- บันทึกไฟล์ชื่อ “robots.txt”

- อัปโหลดไฟล์ไปยังโฟลเดอร์หลักของเว็บไซต์ (root directory) ผ่าน FTP หรือ File Manager ในโฮสติ้งของคุณ

- ตรวจสอบว่าไฟล์สามารถเข้าถึงได้ที่ https://www.yourdomain.com/robots.txt

2. วิธีการสร้างไฟล์ Robots.txt โดยใช้ปลั๊กอิน

สำหรับผู้ใช้ WordPress การสร้าง Robots.txt WordPress ทำได้ง่าย ๆ ด้วยปลั๊กอิน

- Yoast SEO – ปลั๊กอินยอดนิยมนี้มีฟีเจอร์จัดการ Robots.txt ในเมนู “SEO” > “เครื่องมือ” > “แก้ไขไฟล์”

- All in One SEO – ไปที่ “All in One SEO” > “เครื่องมือ” > “Robots.txt Editor”

- Rank Math – เข้าไปที่ “Rank Math” > “ตั้งค่าทั่วไป” > “แก้ไข robots.txt”

วิธีนี้เหมาะสำหรับผู้ที่ไม่ถนัดการแก้ไขไฟล์โดยตรง และช่วยป้องกันข้อผิดพลาดที่อาจเกิดขึ้น การใช้ปลั๊กอินสำหรับจัดการ WordPress Robots.txt ยังมีฟีเจอร์เสริมอื่น ๆ ที่ช่วยในการทำ SEO อีกด้วย

ยกระดับเว็บไซต์ของคุณให้มีประสิทธิภาพมากยิ่งขึ้นกับ CIPHER!

ที่ บริษัทไซเฟอร์ เรามีทีมผู้เชี่ยวชาญด้าน SEO ที่พร้อมช่วยปรับแต่งไฟล์ Robots.txt และองค์ประกอบ SEO อื่น ๆ ของเว็บไซต์คุณให้ทำงานได้อย่างมีประสิทธิภาพสูงสุด

บริการของเรา:

- รับทำเว็บไซต์ พร้อมการวางโครงสร้างที่เป็นมิตรกับ SEO ตั้งแต่เริ่มต้น

- บริการ SEO แบบครบวงจร ทั้ง On-page และ Off-page

- ดูแลและปรับแต่งเว็บไซต์ WordPress รวมถึงการตั้งค่า WordPress Robots.txt อย่างเหมาะสม

- วิเคราะห์และแก้ไขปัญหา SEO ที่อาจเกิดจากการตั้งค่า Robots.txt ไม่ถูกต้อง

การทำ SEO เป็นกระบวนการต่อเนื่อง และ Robots.txt เป็นเพียงส่วนหนึ่งของภาพรวมทั้งหมด หากต้องการผลลัพธ์ที่ดีที่สุด การทำงานร่วมกับผู้เชี่ยวชาญอย่าง CIPHER จะช่วยให้คุณมั่นใจได้ว่าทุกองค์ประกอบของเว็บไซต์ได้รับการปรับแต่งอย่างเหมาะสม